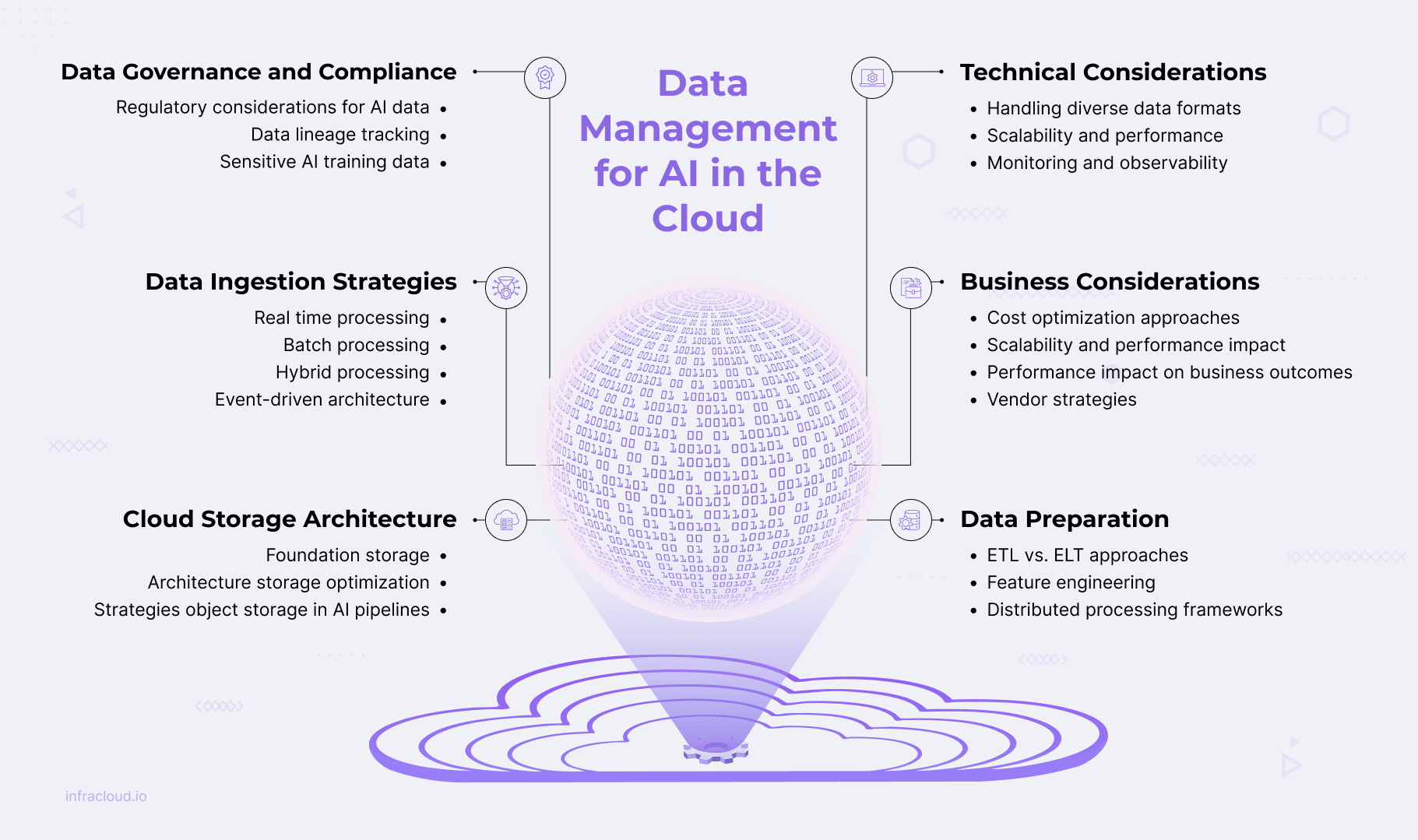

La conexión entre datos e IA

La calidad de los datos determina los resultados de la IA. Esta relación es fundamental, ya que los sistemas de IA desarrollan sus capacidades a través de los datos de entrenamiento y prueba que procesan.

Las métricas clave de la calidad de los datos incluyen:

Precisión

Integridad

Coherencia y

Puntualidad

Los modelos de IA aprenden de los datos ingeridos y responden en función de su calidad: los datos incoherentes producen patrones y predicciones incoherentes. Los enormes volúmenes de datos necesarios para un entrenamiento y una inferencia eficaces de la IA tienden a sobrecargar la infraestructura convencional. La infraestructura en la nube ofrece soluciones escalables que pueden satisfacer estas demandas excepcionales de datos a través de la escalabilidad, la integración de datos sin fisuras a través de diversas fuentes, la optimización de costes a través del almacenamiento por niveles, y sólidas capacidades de seguridad y cumplimiento.

Estrategias de ingestión de datos

La ingesta de datos recopila e importa datos de forma eficiente desde varias fuentes a almacenes o lagos de datos para su análisis. Este proceso incluye estrategias de ingestión de datos, herramientas de ingestión nativas de la nube y técnicas de validación de datos para garantizar la integridad y calidad de los datos, adaptadas a las necesidades de cargas de trabajo de IA específicas.

Las organizaciones pueden implementar múltiples métodos de ingestión para satisfacer las diversas necesidades de procesamiento de IA:

Procesamiento de flujos para datos en tiempo real

Procesamiento por lotes para grandes volúmenes

Procesamiento híbrido que combina ambos enfoques

Arquitectura basada en eventos para la gestión de datos basada en disparadores

Cuando se diseñan adecuadamente, los sistemas de IA integrales pueden gestionar eficazmente tanto las demandas de datos en tiempo real como las históricas.

Las herramientas de ingesta nativas de la nube, eficaces y escalables, trasladan los datos de diversas fuentes a entornos en la nube. Los principales proveedores de servicios en la nube ofrecen herramientas y servicios de ingesta diseñados específicamente para admitir modelos en tiempo real, por lotes o híbridos. Los principales proveedores ofrecen servicios especializados compatibles con varios modelos de ingesta:

AWS ofrece servicios integrales como Kinesis para streaming en tiempo real con capacidades de autoescalado.

Azure ofrece soluciones integradas como concentradores de eventos para el streaming de datos en tiempo real y la ingesta de eventos.

Google Cloud ofrece potentes herramientas, como Pub/Sub para mensajería global y procesamiento de eventos.

Tecnologías de código abierto como Kafka, Flinky NiFi ofrecen alternativas agnósticas a las plataformas que se han adoptado ampliamente en todos los sectores.

La validación de datos durante la ingesta verifica las fuentes y los formatos antes de la carga para evitar que los errores afecten a los procesos posteriores. Las técnicas de validación clave incluyen la validación de esquemas para datos estructurados, marcos especializados para datos no estructurados, perfiles estadísticos para detectar anomalías y puntuación de calidad automatizada.

Comprender la arquitectura de almacenamiento en la nube para la IA

Una arquitectura de almacenamiento en la nube eficaz requiere comprender los sistemas de almacenamiento, las estrategias de gestión de datos y los retos de integración para lograr flujos de trabajo de IA fluidos.

Arquitecturas básicas de almacenamiento

Lago de datos frente a almacén de datos

Lagos de datos almacenan datos en bruto, no estructurados o semiestructurados a escala en formatos nativos. Son ideales para diversos entrenamientos de IA, pero tradicionalmente carecen de aplicación de esquemas y control de versiones.

Los almacenes de datos gestionan datos estructurados con esquemas predefinidos, que son adecuados para la analítica pero menos adaptables para el entrenamiento de IA.

Arquitecturas híbridas de lago de datos

Combinan la escalabilidad del lago de datos con el rendimiento y la coherencia del almacén de datos.

Admiten datos estructurados y no estructurados, ideales para cargas de trabajo de IA/ML

Se basan en formatos de tabla optimizados (Delta Lake, Apache Iceberg, Apache Hudi) para soportar transacciones.

Utilización de metadatos para proporcionar contexto y apoyar la supervisión, la calidad y la capacidad de descubrimiento.

Estrategias de optimización del almacenamiento

La optimización del almacenamiento para cargas de trabajo de IA requiere equilibrar la rentabilidad con las necesidades de rendimiento mediante enfoques estratégicos de colocación de datos y gestión del ciclo de vida.

Almacenamiento por niveles

Divide los datos en capas en función del uso y la prioridad

Almacenamiento en caliente: Datos de acceso de alta frecuencia (entradas en tiempo real)

Almacenamiento en caliente: Datos de acceso de baja frecuencia (conjuntos de validación)

Almacenamiento en frío: Datos de archivo (registros históricos, copias de seguridad de modelos)

Gestión del ciclo de vida de los datos

Gestiona los conjuntos de datos según su valor y frecuencia de uso

Implementa políticas de retención de datos y procesos de archivo.

Utiliza la clasificación automatizada por niveles para mover los datos entre los niveles de coste en función de los patrones de acceso.

Consideraciones sobre el rendimiento

El entrenamiento de IA requiere un alto rendimiento para conjuntos de datos masivos

Aborda los cuellos de botella de E/S con soluciones de alto rendimiento (SSD NVMe, sistemas de archivos distribuidos).

Utilizar la aceleración de hardware (GPU, TPU) para la eficiencia del procesamiento

Almacenamiento de objetos en pipelines de IA

El almacenamiento de objetos se ha convertido en la piedra angular de las modernas canalizaciones de IA debido a su escalabilidad, resistencia y eficiencia económica para almacenar datos no estructurados. Se integra a la perfección con marcos de IA populares como TensorFlow, PyTorch y Hugging Face a través de API estandarizadas, a la vez que admite operaciones ETL esenciales mediante herramientas como Apache Spark y AWS Glue. Los enfoques basados en metadatos mejoran la organización y la gobernanza de los activos de IA mediante un seguimiento eficaz de las versiones de los conjuntos de datos y los parámetros de los modelos. Las estrategias de control de versiones para los conjuntos de datos de entrenamiento, incluidas las instantáneas y el etiquetado de metadatos, garantizan la reproducibilidad de los modelos de IA y permiten la reversión cuando es necesario.

Las organizaciones pueden optimizar significativamente los costes sin dejar de cumplir los requisitos de rendimiento de la IA si implementan cuidadosamente arquitecturas de almacenamiento adecuadas, estrategias de niveles e integración de almacenamiento de objetos.

Herramientas de cálculo de costes en la nube como Calculadora de precios de AWS, Gestión de costes de Azurey Calculadora de precios de la nube de Google facilitan el modelado de costes mediante el análisis del coste total de propiedad y la planificación de escenarios. Este enfoque equilibrado garantiza que las inversiones en almacenamiento se alineen con los patrones de uso reales y el valor empresarial, lo que permite una infraestructura de IA escalable que sigue siendo económicamente viable a medida que crecen las cargas de trabajo.

Preparación de los datos para la IA

Antes de que los modelos de IA puedan proporcionar información útil, los datos deben convertirse para que sean adecuados para los modelos de ML. Esta conversión hace que los datos estén listos para ser limpios, bien controlados, seguros, imparciales, precisos, estructurados y presentados de forma coherente. El procesamiento de datos es un paso crítico en la preparación de los datos para ser utilizados por las aplicaciones de IA.

Enfoques ETL frente a ELT en entornos de nube

ETL (Extract, Transform, Load) y ELT (Extract, Load, Transform) representan dos metodologías fundamentales de integración de datos con ventajas distintas en entornos de nube:

ETL extrae datos en bruto, los transforma en un formato estructurado y los carga en almacenes de datos.

ELT importa los datos brutos directamente a los almacenes y realiza las transformaciones necesarias, aprovechando la escalabilidad de la nube.

La adopción de la nube ha cambiado la preferencia hacia ELT por su flexibilidad, ejecución más rápida y mejor alineación con las cargas de trabajo de IA. Este cambio afecta a los flujos de trabajo de procesamiento de datos a través de:

Arquitectura sin servidor que transforma ambos enfoques (AWS Glue, Azure Data Factory)

Estrategias de orquestación que gestionan secuencias de transformación (Apache Airflow, Kubeflow Pipelines)

Marcos de procesamiento optimizados para cargas de trabajo específicas (Spark para ETL, Presto para consultas ELT)

Gestión de esquemas enfoques que manejan formatos de datos en evolución

Técnicas de ingeniería de características y preparación de datos

La ingeniería de características transforma los datos brutos en características útiles que mejoran el aprendizaje y el rendimiento del modelo. A continuación se indican algunas técnicas clave utilizadas para la ingeniería de características:

Normalización y estandarización para garantizar que las características contribuyan proporcionalmente

Imputación y eliminación para tratar los datos que faltan

Reducción de la dimensionalidad (PCA, UMAP) para aproximar conjuntos de datos con menos características

Enfoques especializados para datos de series temporales

La ingeniería de características suele requerir operaciones informáticas intensivas en grandes conjuntos de datos, por lo que los marcos informáticos distribuidos se han convertido en activos fundamentales en el proceso de preparación de datos de la IA.

Papel de los marcos de procesamiento distribuido

A medida que aumenta la complejidad de los modelos de IA, el procesamiento distribuido se vuelve esencial para gestionar grandes conjuntos de datos y cargas de trabajo computacionales:

Frameworks como Spark, Dasky Ray permiten el procesamiento escalable a través de múltiples nodos

La aceleración de la GPU a través de las librerías NVIDIA RAPIDS mejora el rendimiento

La contenedorización a través de Docker y Kubernetes mejora la fiabilidad y la gestión de recursos

Los marcos de procesamiento y las plataformas de IA se integran a través de API, conectores y herramientas de orquestación como Apache Airflow y Kubeflow.

Estos enfoques interconectados garantizan que los datos se preparen adecuadamente y estén listos para la IA, formando la base para el desarrollo y despliegue exitosos de modelos. Estas herramientas y técnicas garantizan que los datos estén preparados para la IA, desde enfoques eficaces de ETL y ELT hasta ingeniería de características y arquitecturas de procesamiento distribuido.

Gobernanza y conformidad de los datos

Los sistemas de IA requieren marcos de gobernanza sólidos para garantizar el cumplimiento, mantener las normas éticas y generar confianza en los usuarios. A medida que las organizaciones aprovechan modelos de IA cada vez más sofisticados entrenados en vastos conjuntos de datos, la gobernanza se vuelve fundamental para gestionar los riesgos, garantizar la transparencia y cumplir los requisitos normativos.

Consideraciones normativas para los datos de IA

Marcos normativos como el Reglamento General de Protección de Datos (GDPR) y la Ley de Privacidad del Consumidor de California(CCPA) establecen normas y reglamentos estrictos para el tratamiento de datos personales. Estos marcos son especialmente relevantes para los sistemas de IA que utilizan conjuntos de datos masivos con información sensible o identificable. Una regulación clave es la residencia de datos, que requiere que ciertos datos permanezcan dentro de límites geográficos específicos, abordados a través de centros de datos regionales o fragmentación geográfica de datos.

La privacidad por diseño incorpora de forma proactiva la privacidad en el diseño de los sistemas de IA mediante técnicas de minimización, seudonimización y anonimización de datos. El derecho al borrado permite a las personas solicitar la eliminación de datos en todos los sistemas, mientras que las plataformas de gestión del consentimiento como OneTrust y TrustArc facilitan la recogida de datos conforme a la normativa y el control detallado por parte del usuario.

Aunque los marcos normativos anteriores aclaran lo que debe protegerse, los marcos de explicabilidad y trazabilidad aclaran cómo tiene lugar el tratamiento de datos. Esto empieza con los sistemas de seguimiento del linaje de los datos.

Seguimiento del linaje de los datos

El linaje de datos supervisa todo el ciclo de vida de los datos, mejorando la transparencia y la explicabilidad. El linaje de datos es crucial para la validación de modelos, la auditoría y la asignación del contexto empresarial a los flujos de trabajo técnicos en contextos de IA regulados o de alto riesgo.

Varias herramientas, como Azure Purview, AWS Glue Data Catalog, etc., y algunos marcos de código abierto, como Apache Atlas y OpenLineage, admiten la captura automatizada del linaje.

Enfoques de seguridad de datos para datos de entrenamiento de IA confidenciales

Proteger los datos de entrenamiento confidenciales requiere múltiples capas de seguridad adaptadas a los flujos de trabajo de la IA.

El cifrado protege los datos en reposo y en tránsito, mientras que la tokenización y el enmascaramiento sustituyen los datos confidenciales por tokens o caracteres marcadores de posición.

El control de acceso basado en roles asigna permisos en función de los roles organizativos, garantizando un acceso adecuado a los datos.

La privacidad diferencial introduce ruido controlado para evitar la identificación de individuos en los conjuntos de datos de entrenamiento, y la computación multipartita segura permite el desarrollo colaborativo de la IA sin revelar entradas propietarias.

Consideraciones técnicas para la introducción y el procesamiento de datos

La ingestión de datos es esencial para crear sistemas eficientes de IA y análisis, recopilando y transformando datos de diversas fuentes y enviándolos a bases de datos o lagos de datos para su procesamiento.

Manejo de diversos formatos y fuentes de datos

Los formatos semiestructurados como JSON, XML y AVRO requieren técnicas de ingestión especializadas debido a la flexibilidad de sus esquemas. Los datos no estructurados (texto, imágenes y vídeos) requieren un preprocesamiento en formatos estructurados mediante herramientas de procesamiento del lenguaje natural (PLN) y bibliotecas de procesamiento de imágenes. La ingestión de datos basada en API desde aplicaciones SaaS aprovecha las solicitudes HTTP manteniendo los límites de velocidad de la API para acceder a los datos.

Aunque la gestión eficaz de los distintos formatos de datos es fundamental, también lo es asegurarse de que la arquitectura de soporte se escalará y rendirá para hacer frente a los distintos niveles de datos y requisitos de procesamiento.

Escalabilidad y rendimiento

El escalado dinámico de las canalizaciones de datos de IA gestiona cargas de trabajo crecientes utilizando mecanismos de autoescalado como Kubernetes Autoescalado horizontal de pods. Las canalizaciones de ingesta de datos utilizan colas de mensajes, búferes profundosy limitación de velocidad para almacenar datos durante los picos de tráfico con el fin de reducir la pérdida de datos y mantener un procesamiento fluido.

El procesamiento paralelo divide grandes conjuntos de datos en trozos más pequeños para la ingesta simultánea. La partición de datos y la fragmentación son técnicas habituales en el procesamiento paralelo de datos.

Los conductos de ingestión deben gestionar los errores con elegancia mediante mecanismos de reintento utilizando un backoff exponencial. Las operaciones idempotentes garantizan que los eventos fallidos se reintenten sin causar un procesamiento duplicado. Algunas de las principales estrategias para optimizar el rendimiento de la ingesta son la asignación de recursos a tareas de ingesta críticas, la compresión para reducir el tamaño de los datos y la optimización a nivel de red para aumentar la velocidad y la fiabilidad.

Una vez garantizados el rendimiento y la escalabilidad máximos, la supervisión y la observabilidad continuas siguen siendo fundamentales para mantener la salud y el rendimiento del canal de ingesta de datos.

Supervisión y observabilidad

La supervisión mantiene la fiabilidad de la canalización a través de métricas como la tasa de ingestión de datos, la latencia del procesamiento, la detección de anomalías y las tasas de error. Para los sistemas que procesan datos rápidamente y manejan muchos datos, como los análisis en tiempo real o las canalizaciones de IA, la supervisión de estas métricas ayuda a cumplir los acuerdos de nivel de servicio (SLA). Las alertas en tiempo real a través de umbrales y detección de anomalías permiten una rápida identificación y resolución de problemas. Prometheus y Grafana son muy eficaces para la supervisión en tiempo real.

El seguimiento de datos de extremo a extremo mediante el linaje de datos y el rastreo distribuido proporciona transparencia en el movimiento de datos. El registro estructurado en sistemas centralizados admite la depuración y la optimización del rendimiento.

Al implementar prácticas sólidas de monitoreo y observabilidad, las empresas pueden garantizar la confiabilidad, el rendimiento y la calidad de su canal de ingestión de datos.

Consideraciones empresariales para el almacenamiento de datos de IA

Al desarrollar cargas de trabajo de IA, las consideraciones empresariales como la optimización de costes, la planificación de la escalabilidad, el impacto en el rendimiento y las estrategias de proveedores son fundamentales para garantizar una infraestructura de datos eficiente y preparada para el futuro.

Enfoques de optimización de costes

Las estrategias incluyen la comprensión del coste total de propiedad (TCO) en todas las clases de almacenamiento, la aplicación de políticas de ciclo de vida de los datos para el archivado automatizado, el uso de técnicas de compresión para reducir las necesidades de almacenamiento y el dimensionamiento correcto de la infraestructura para evitar el sobreaprovisionamiento. Una gestión eficaz de los costes requiere analizar tanto los costes directos de almacenamiento como los gastos indirectos, como los gastos generales de gestión, las tasas de transferencia de datos y las repercusiones en el rendimiento.

Escalabilidad e impacto en el rendimiento

La asignación presupuestaria puede basarse en el crecimiento previsto de los datos y en los requisitos de rendimiento para ampliar la capacidad de almacenamiento. Las herramientas basadas en la nube permiten la proyección de datos para tomar mejores decisiones de inversión en almacenamiento. Los modelos de previsión, como la regresión lineal o el crecimiento exponencial, y el análisis del uso histórico pueden utilizarse para predecir las necesidades de almacenamiento para las metodologías de planificación de la capacidad. La identificación temprana de posibles cuellos de botella ayuda a las organizaciones a desarrollar estrategias de mitigación antes de que estas limitaciones afecten a las operaciones.

Impacto del rendimiento en los resultados empresariales

El rendimiento del almacenamiento afecta directamente a la formación y el despliegue de modelos de IA. Un acceso lento a los datos y una latencia elevada se traducen en recursos de GPU/TPU ociosos, mayores costes y un desarrollo más lento. Las cargas de trabajo en tiempo real, como la detección de fraudes o anomalías, se ven afectadas de forma desproporcionada. Almacenamiento de alto rendimiento (por ejemplo, SSD NVMe, sistemas de archivos paralelos) y canalizaciones de datos optimizadas para eliminar la E/S redundante.

Herramientas de medición como FIO e IOmeter ayudan a modelar los patrones de E/S y a supervisar métricas clave como IOPS, rendimiento y latencia para encontrar y solucionar cuellos de botella en el rendimiento.

Al tiempo que tienen en cuenta los factores de coste, escalabilidad y rendimiento, las empresas también pueden elaborar un enfoque estratégico de selección de proveedores que sopese estas consideraciones entre sí y, al mismo tiempo, proporcione flexibilidad para futuras necesidades.

Estrategias de proveedores

La selección estratégica de proveedores garantiza la flexibilidad, escalabilidad y rentabilidad de la IA basada en la nube y las cargas de trabajo de gestión de datos. Los proveedores de la nube deben seleccionarse con cuidado al diseñar el almacenamiento basado en la nube para las cargas de trabajo de IA.

La nube única ofrece simplicidad e integración, mientras que la nube múltiple proporciona flexibilidad y evita la dependencia del proveedor. Al evaluar posibles proveedores de almacenamiento, considere (i) dar prioridad a los proveedores con SLA elevados (p. ej., tiempo de actividad del 99,99% o superior), (ii) evaluar los riesgos de bloqueo del almacenamiento, ya que depender en gran medida de las herramientas y formatos de almacenamiento patentados de un único proveedor puede causar problemas si es necesario cambiar de proveedor más adelante, (iii) garantizar una migración fluida de las cargas de trabajo y el almacenamiento para mantener intacta la agilidad.

Palabras finales

El éxito de la IA en la nube depende de una gestión eficaz de los datos que conecte el avance tecnológico con el valor empresarial. Los datos deben optimizarse en cuanto a escala, seguridad, rendimiento, coste y cumplimiento durante todo su ciclo de vida.

Las tecnologías en la nube ofrecen plataformas escalables y flexibles para gestionar modelos de datos de IA complejos. Al aprovechar las soluciones nativas de la nube y las mejores prácticas, las empresas pueden impulsar la innovación y permitir una toma de decisiones informada. Las estrategias de ingesta de datos que hemos explorado admiten diversos flujos de datos en los sistemas de IA, permitiendo tanto el procesamiento en tiempo real como por lotes con baja latencia y alto rendimiento.

De cara al futuro, la gestión de datos de IA seguirá evolucionando con la gobernanza automatizada, lagos sin servidor, arquitecturas que preserven la privacidad y prácticas sostenibles. Los líderes empresariales y los arquitectos deben priorizar la inversión en infraestructura de datos moderna basada en la nube y la gobernanza para las capacidades de IA a prueba de futuro y promover la colaboración interfuncional, alineando las estrategias de datos con los objetivos empresariales.

¿Está preparado para dar el siguiente paso en la innovación impulsada por la IA? Si necesita ayuda para ampliar o crear su infraestructura de IA, póngase en contacto con nosotros hoy mismo.