Le lien entre les données et l'IA

La qualité des données détermine les résultats de l'IA. Cette relation est fondamentale, car les systèmes d'IA développent leurs capacités grâce aux données d'entraînement et de test qu'ils traitent.

Les principales mesures de la qualité des données sont les suivantes

l'exactitude

l'exhaustivité

Cohérence, et

l'actualité.

Les modèles d'IA apprennent à partir des données ingérées et réagissent en fonction de leur qualité - des données incohérentes produisent des modèles et des prédictions incohérents. Les volumes massifs de données nécessaires à l'apprentissage et à l'inférence efficaces de l'IA tendent à surcharger les infrastructures conventionnelles. L'infrastructure cloud fournit des solutions évolutives qui peuvent répondre à ces demandes exceptionnelles de données grâce à l'évolutivité, à l'intégration transparente des données à travers diverses sources, à l'optimisation des coûts grâce à la hiérarchisation du stockage et à de solides capacités de sécurité et de conformité.

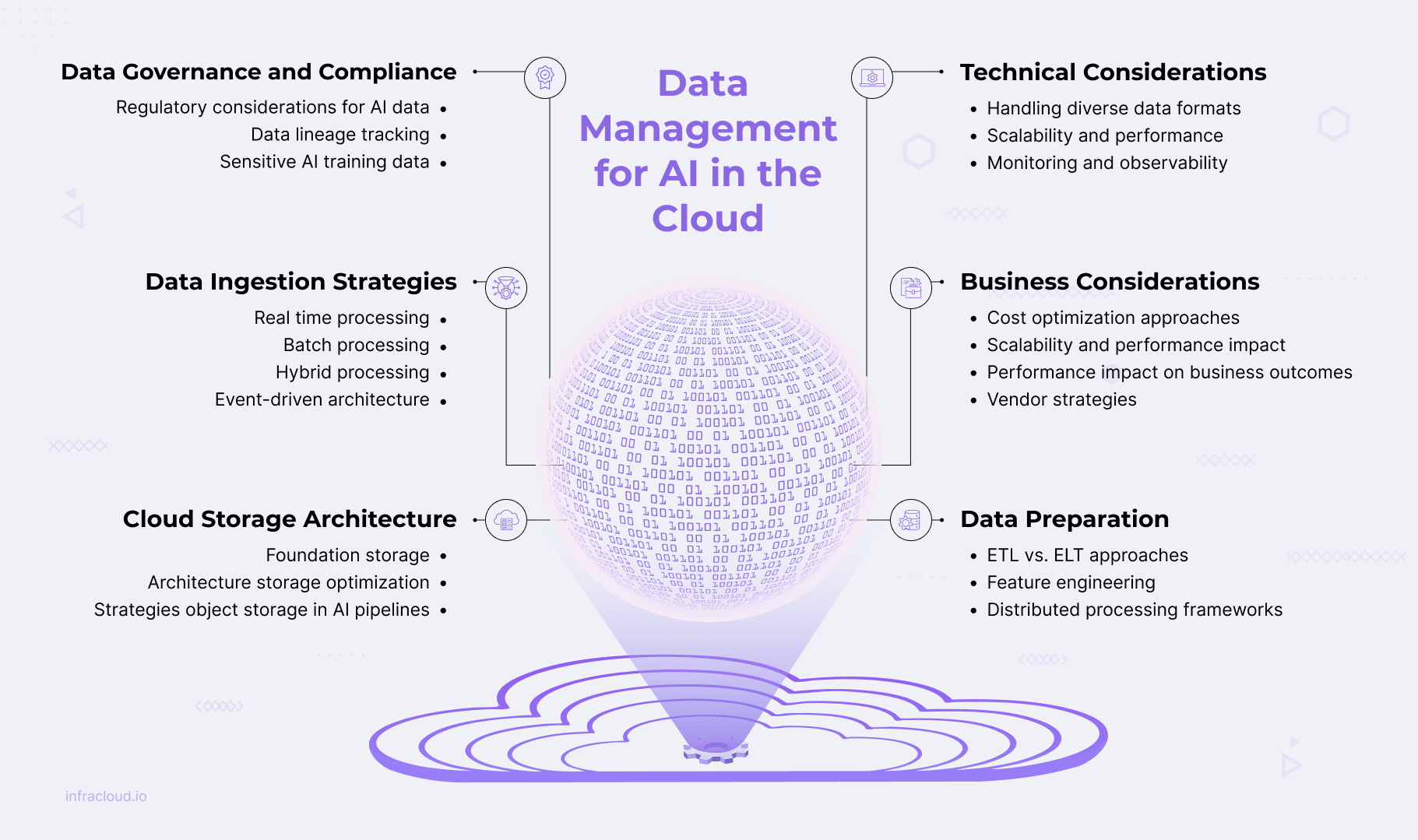

Stratégies d'ingestion des données

L'ingestion de données permet de rassembler et d'importer efficacement des données provenant de diverses sources dans des entrepôts de données ou des lacs à des fins d'analyse. Ce processus comprend des stratégies d'ingestion de données, des outils d'ingestion natifs du cloud et des techniques de validation des données pour garantir l'intégrité et la qualité des données, adaptées aux besoins des charges de travail d'IA spécifiques.

Les organisations peuvent mettre en œuvre plusieurs méthodes d'ingestion pour répondre aux divers besoins de traitement de l'IA :

Traitement en flux pour les données en temps réel

Traitement par lots pour les gros volumes

Traitement hybride combinant les deux approches

Architecture pilotée par les événements pour un traitement des données basé sur les déclencheurs.

Lorsqu'ils sont correctement conçus, les systèmes d'IA de bout en bout peuvent gérer efficacement les demandes de données en temps réel et historiques.

Des outils d'ingestion efficaces et évolutifs, natifs de l'informatique en nuage, déplacent les données de diverses sources vers des environnements en nuage. Les principaux fournisseurs de cloud proposent des outils et des services d'ingestion spécialement conçus pour prendre en charge les modèles en temps réel, par lots ou hybrides. Les principaux fournisseurs proposent des services spécialisés prenant en charge différents modèles d'ingestion :

AWS propose des services complets tels que Kinesis pour le streaming en temps réel avec des capacités de mise à l'échelle automatique.

Azure propose des solutions intégrées telles que Event Hubs pour le streaming de données en temps réel et l'ingestion d'événements.

Google Cloud fournit des outils puissants, notamment Pub/Sub pour la messagerie globale et le traitement des événements.

Les technologies open-source telles que Kafka, Flinket NiFi offrent des alternatives indépendantes de la plateforme qui sont largement adoptées dans tous les secteurs d'activité.

La validation des données pendant l'ingestion vérifie les sources et les formats avant le chargement afin d'éviter que les erreurs n'affectent les processus en aval. Les principales techniques de validation comprennent la validation des schémas pour les données structurées, les cadres spécialisés pour les données non structurées, le profilage statistique pour détecter les anomalies et la notation automatisée de la qualité.

Comprendre l'architecture de stockage en nuage pour l'IA

Une architecture de stockage cloud efficace nécessite de comprendre les systèmes de stockage, les stratégies de gestion des données et les défis d'intégration pour des flux de travail d'IA transparents.

Architectures de stockage de base

Lac de données ou entrepôt de données

Les lacs de données stockent des données brutes, non structurées ou semi-structurées à grande échelle dans des formats natifs. Ils sont idéaux pour divers entraînements d'IA, mais manquent traditionnellement d'application de schémas et de versionnage.

Les entrepôts de données gèrent des données structurées avec des schémas prédéfinis, qui conviennent à l'analyse mais sont moins adaptables à la formation à l'IA.

Architectures hybrides de lacs de données

Combinent l'évolutivité du lac de données avec les performances et la cohérence de l'entrepôt de données

Prennent en charge les données structurées et non structurées, ce qui est idéal pour les charges de travail d'IA/ML.

S'appuient sur des formats de table optimisés (Delta Lake, Apache Iceberg, Apache Hudi) pour la prise en charge des transactions.

Utiliser les métadonnées pour fournir un contexte, prendre en charge la surveillance, la qualité et la découvrabilité.

Stratégies d'optimisation du stockage

L'optimisation du stockage pour les charges de travail d'IA nécessite d'équilibrer la rentabilité et les besoins de performance grâce à des approches stratégiques de placement des données et de gestion du cycle de vie.

Hiérarchisation du stockage

Divise les données en couches en fonction de l'utilisation et de la priorité.

Stockage à chaud: Données d'accès à haute fréquence (entrées en temps réel).

Stockage à chaud: Données d'accès à faible fréquence (ensembles de validation)

Stockage à froid: Données d'archivage (journaux historiques, sauvegardes de modèles)

Gestion du cycle de vie des données

Gestion des ensembles de données en fonction de leur valeur et de leur fréquence d'utilisation

Mise en œuvre de politiques de conservation des données et de processus d'archivage

Utilisation de la hiérarchisation automatisée pour déplacer les données entre les niveaux de coûts en fonction des schémas d'accès.

Considérations relatives aux performances

La formation à l'IA nécessite un débit élevé pour les ensembles de données massifs.

Résoudre les goulets d'étranglement des E/S avec des solutions hautes performances (disques SSD NVMe, systèmes de fichiers distribués).

Utiliser l'accélération matérielle (GPU, TPU) pour améliorer l'efficacité du traitement.

Stockage d'objets dans les pipelines d'IA

Le stockage d'objets est devenu la pierre angulaire des pipelines d'IA modernes en raison de son évolutivité, de sa résilience et de sa rentabilité pour le stockage de données non structurées. Il s'intègre de manière transparente aux frameworks d'IA les plus répandus, tels que TensorFlow, PyTorch et Hugging Face, grâce à des API standardisées, tout en prenant en charge les opérations ETL essentielles via des outils tels qu'Apache Spark et AWS Glue. Les approches basées sur les métadonnées améliorent l'organisation et la gouvernance des ressources d'IA en assurant un suivi efficace des versions des ensembles de données et des paramètres des modèles. Les stratégies de versionnement des ensembles de données d'entraînement, y compris l'instantané et le marquage des métadonnées, garantissent la reproductibilité des modèles d'IA et permettent des retours en arrière en cas de besoin.

Les entreprises peuvent optimiser considérablement leurs coûts tout en répondant aux exigences de performance de l'IA en mettant en œuvre de manière réfléchie des architectures de stockage appropriées, des stratégies de hiérarchisation et l'intégration du stockage d'objets.

Les outils de calcul des coûts du cloud tels que Calculateur de prix AWS, Azure Cost Managementet Calculateur de prix Google Cloud facilitent la modélisation des coûts grâce à l'analyse du coût total de possession et à la planification de scénarios. Cette approche équilibrée garantit que les investissements dans le stockage s'alignent sur les modèles d'utilisation réels et la valeur commerciale, permettant ainsi une infrastructure d'IA évolutive qui reste économiquement viable au fur et à mesure que les charges de travail augmentent.

Préparer les données pour l'IA

Avant que les modèles d'IA puissent fournir des informations utiles, les données doivent être converties pour être adaptées aux modèles de ML. Cette conversion permet aux données d'être propres, bien gouvernées, sécurisées, impartiales, précises, structurées et présentées de manière cohérente. Le traitement des données est une étape critique dans la préparation des données à utiliser par les applications d'IA.

Approches ETL et ELT dans les environnements en nuage

L'ETL (Extract, Transform, Load) et l'ELT (Extract, Load, Transform) sont deux méthodologies fondamentales d'intégration des données qui présentent des avantages distincts dans les environnements en nuage :

ETL extrait des données brutes, les transforme sous une forme structurée et les charge dans des entrepôts de données.

ELT importe les données brutes directement dans les entrepôts et effectue les transformations nécessaires, en tirant parti de l'évolutivité de l'informatique en nuage.

L'adoption du cloud a fait évoluer les préférences vers l'ELT pour sa flexibilité, son exécution plus rapide et son meilleur alignement avec les charges de travail de l'IA. Ce changement a un impact sur les flux de travail de traitement des données à travers :

L'architecture sans serveur qui transforme les deux approches (AWS Glue, Azure Data Factory)

Stratégies d'orchestration qui gèrent les séquences de transformation (Apache Airflow, Kubeflow Pipelines)

Des cadres de traitement optimisés pour des charges de travail spécifiques (Spark pour l'ETL, Presto pour les requêtes ELT)

Gestion des schémas approches permettant de gérer l'évolution des formats de données

Techniques d'ingénierie des caract�éristiques et de préparation des données

Le Feature engineering transforme les données brutes en caractéristiques utiles qui renforcent l'apprentissage et améliorent les performances des modèles. Voici quelques techniques clés utilisées pour l'ingénierie des caractéristiques :

Normalisation et standardisation pour s'assurer que les caractéristiques contribuent de manière proportionnelle

Imputation et suppression stratégies de traitement des données manquantes

Réduction de la dimensionnalité (ACP, UMAP) pour approximer les ensembles de données avec moins de caractéristiques

Approches spécialisées pour les données de séries temporelles

L'ingénierie des caractéristiques nécessite généralement des opérations de calcul intensif sur de grands ensembles de données ; les cadres informatiques distribués sont donc devenus des atouts essentiels dans le processus de préparation des données de l'IA.

Rôle des cadres de traitement distribué

À mesure que les modèles d'IA gagnent en complexité, le traitement distribué devient essentiel pour gérer les grands ensembles de données et les charges de travail informatiques :

Des frameworks tels que Spark, Dasket Ray permettent un traitement évolutif sur plusieurs nœuds

L'accélération GPU via les bibliothèques NVIDIA RAPIDS améliore les performances.

La conteneurisation via Docker et Kubernetes améliore la fiabilité et la gestion des ressources.

Les cadres de traitement et les plateformes d'IA sont intégrés par le biais d'API, de connecteurs et d'outils d'orchestration comme Apache Airflow et Kubeflow.

Ces approches interconnectées garantissent que les données sont correctement préparées et prêtes pour l'IA, formant ainsi la base d'un développement et d'un déploiement de modèles réussis. Ces outils et techniques garantissent que les données sont prêtes pour l'IA, qu'il s'agisse d'approches ETL et ELT efficaces, d'ingénierie des fonctionnalités ou d'architectures de traitement distribuées.

Gouvernance des données et conformité

Les systèmes d'IA nécessitent des cadres de gouvernance solides pour garantir la conformité, maintenir des normes éthiques et renforcer la confiance des utilisateurs. Alors que les organisations exploitent des modèles d'IA de plus en plus sophistiqués formés sur de vastes ensembles de données, la gouvernance devient centrale pour gérer les risques, assurer la transparence et répondre aux exigences réglementaires.

Considérations réglementaires pour les données d'IA

Les cadres réglementaires tels que le Règlement général sur la protection des données (GDPR) et le California Consumer Privacy Act(CCPA) définissent des règles et des réglementations strictes pour le traitement des données à caractère personnel. Ces cadres sont particulièrement pertinents pour les systèmes d'IA qui utilisent des ensembles de données massives impliquant des informations sensibles ou identifiables. L'une des principales réglementations est la résidence des données, qui exige que certaines données restent à l'intérieur de limites géographiques spécifiques, traitées par le biais de centres de données régionaux ou le partage de données basé sur la géographie.

La protection de la vie privée dès la conception intègre de manière proactive la protection de la vie privée dans la conception des systèmes d'IA grâce à des techniques de minimisation, de pseudonymisation et d'anonymisation des données. Le droit à l'effacement permet aux individus de demander la suppression de leurs données dans tous les systèmes, tandis que les plateformes de gestion du consentement telles que OneTrust et TrustArc facilitent la collecte de données conformes et le contrôle fin de l'utilisateur.

Bien que les cadres réglementaires susmentionnés précisent ce qui doit être protégé, les cadres d'explicabilité et de traçabilité précisent comment le traitement des données a lieu. Cela commence par les systèmes de suivi des données.

Suivi des données

La traçabilité des données permet de suivre l'ensemble du cycle de vie des données, améliorant ainsi la transparence et la capacité d'explication. Le suivi des données est essentiel pour la validation des modèles, l'audit et la mise en correspondance du contexte commercial avec les flux de travail techniques dans les contextes d'IA à haut risque ou réglementés.

Plusieurs outils, tels que Azure Purview, AWS Glue Data Catalog, etc., et quelques frameworks open source, tels qu'Apache Atlas et OpenLineage, prennent en charge la capture automatisée du lignage.

Approches de la sécurité des données pour les données d'entraînement sensibles de l'IA

La protection des données d'entraînement sensibles nécessite plusieurs couches de sécurité adaptées aux flux de travail de l'IA.

Le chiffrement protège les données au repos et en transit, tandis que la tokenisation et le masquage remplacent les données sensibles par des jetons ou des caractères de substitution.

Le contrôle d'accès basé sur les rôles attribue des autorisations en fonction des rôles organisationnels, garantissant ainsi un accès approprié aux données.

La confidentialité différentielle introduit un bruit contrôlé pour empêcher l'identification des individus dans les ensembles de données de formation, et le calcul multipartite sécurisé permet le développement collaboratif de l'IA sans révéler les données propriétaires.

Considérations techniques pour l'ingestion et le traitement des données

L'ingestion de données est essentielle pour créer des systèmes d'IA et d'analyse efficaces, en collectant et en transformant des données provenant de diverses sources et en les acheminant vers des bases de données ou des lacs de données en vue de leur traitement.

Traitement de divers formats et sources de données

Les formats semi-structurés tels que JSON, XML et AVRO nécessitent des techniques d'ingestion spécialisées en raison de la flexibilité des schémas. Les données non structurées (texte, images et vidéos) nécessitent un prétraitement dans des formats structurés à l'aide d'outils de traitement du langage naturel (NLP) et de bibliothèques de traitement d'images. L'ingestion de données basée sur l'API à partir d'applications SaaS exploite les requêtes HTTP tout en respectant les limites de débit de l'API pour accéder aux données.

S'il est essentiel de gérer efficacement les différents formats de données, il est également essentiel de s'assurer que l'architecture de support sera évolutive et performante pour gérer les différents niveaux de données et d'exigences de traitement.

Évolutivité et performances

La mise à l'échelle dynamique des pipelines de données d'IA gère les charges de travail croissantes à l'aide de mécanismes de mise à l'échelle automatique tels que Kubernetes. Pod Autoscaler horizontal. Les pipelines d'ingestion de données utilisent des files d'attente de messages, tampons profondsLes pipelines d'acquisition de données utilisent des files d'attente de messages, des tampons profonds et la limitation de débit pour mettre en mémoire tampon les données pendant les pics de trafic afin de réduire les pertes de données et de maintenir un traitement fluide.

Le traitement parallèle divise les grands ensembles de données en petits morceaux pour une ingestion simultanée. Le partitionnement des données et le partage sont des techniques couramment utilisées pour le traitement parallèle des données.

Les pipelines d'ingestion doivent traiter les erreurs avec élégance grâce à des mécanismes de réessai à l'aide d'un backoff exponentiel. Les opérations idempotentes garantissent que les événements qui ont échoué sont réessayés sans causer de double traitement. Parmi les principales stratégies d'optimisation des performances d'ingestion figurent l'allocation de ressources pour les tâches d'ingestion critiques, la compression pour réduire la taille des données et l'optimisation au niveau du réseau pour la vitesse et la fiabilité.

Une fois les performances et l'évolutivité maximales assurées, la surveillance et l'observabilité continues restent essentielles pour maintenir la santé et les performances du pipeline d'ingestion de données.

Surveillance et observabilité

La surveillance permet de maintenir la fiabilité du pipeline grâce à des mesures telles que le taux d'ingestion des données, la latence du traitement, la détection des anomalies et les taux d'erreur. Pour les systèmes qui traitent les données rapidement et en grande quantité, comme les pipelines d'analyse en temps réel ou d'IA, la surveillance de ces mesures permet de respecter les accords de niveau de service (SLA). L'alerte en temps réel via des seuils et la détection d'anomalies permet d'identifier et de résoudre rapidement les problèmes. Prometheus et Grafana sont très efficaces pour la surveillance en temps réel.

Le suivi de bout en bout des données à l'aide du lignage des données et du traçage distribué assure la transparence du mouvement des données. La journalisation structurée dans les systèmes centralisés prend en charge le débogage et l'optimisation des performances.

En mettant en œuvre des pratiques robustes de surveillance et d'observabilité, les entreprises peuvent garantir la fiabilité, la performance et la qualité de leur pipeline d'ingestion de données.

Considérations commerciales pour le stockage des données d'IA

Lors du développement de charges de travail d'IA, les considérations commerciales telles que l'optimisation des coûts, la planification de l'évolutivité, l'impact sur les performances et les stratégies des fournisseurs sont essentielles pour garantir une infrastructure de données efficace et prête pour l'avenir.

Approches d'optimisation des coûts

Les stratégies comprennent la compréhension du coût total de possession (TCO) à travers les classes de stockage, la mise en œuvre de politiques de cycle de vie des données pour l'archivage automatisé, l'utilisation de techniques de compression pour réduire les besoins de stockage, et le dimensionnement de l'infrastructure pour éviter le surapprovisionnement. Pour gérer efficacement les coûts, il faut analyser à la fois les coûts de stockage directs et les dépenses indirectes telles que les frais généraux de gestion, les frais de transfert de données et l'impact sur les performances.

Évolutivité et impact sur les performances

L'allocation du budget peut être basée sur la croissance prévue des données et les exigences de performance pour augmenter la capacité de stockage. Les outils basés sur le cloud permettent de projeter les données afin de prendre de meilleures décisions en matière d'investissement dans le stockage. Des modèles de prévision tels que la régression linéaire ou la croissance exponentielle, et l'analyse de l'utilisation historique peuvent être utilisés pour prévoir les besoins de stockage dans le cadre des méthodologies de planification de la capacité. L'identification précoce des goulets d'étranglement potentiels aide les organisations à élaborer des stratégies d'atténuation avant que ces contraintes n'aient un impact sur les opérations.

Impact des performances sur les résultats de l'entreprise

Les performances de stockage ont un impact direct sur la formation et le déploiement des modèles d'IA. Un accès lent aux données et une latence élevée se traduisent par des ressources GPU/TPU inutilisées, des coûts plus élevés et un développement plus lent. Les charges de travail en temps réel telles que la fraude ou la détection d'anomalies sont affectées de manière disproportionnée. Stockage haute performance (par exemple, disques SSD NVMe, systèmes de fichiers parallèles) et pipelines de données optimisés pour éliminer les E/S redondantes.

Des outils de mesure tels que FIO et IOmeter aident à modéliser les modèles d'E/S et à surveiller les mesures clés telles que l'IOPS, le débit et la latence afin de trouver et de corriger les goulets d'étranglement en matière de performances.

Tout en tenant compte des facteurs de coût, d'évolutivité et de performance, les entreprises peuvent également élaborer une approche stratégique de sélection des fournisseurs qui pondère ces considérations les unes par rapport aux autres tout en offrant une certaine flexibilité pour les besoins futurs.

Stratégies des fournisseurs

La sélection stratégique des fournisseurs garantit la flexibilité, l'évolutivité et la rentabilité des charges de travail d'IA et de gestion des données basées sur le cloud. Les fournisseurs de cloud doivent être sélectionnés avec soin lors de l'architecture du stockage basé sur le cloud pour les charges de travail d'IA.

Le cloud unique offre la simplicité et l'intégration, tandis que le multi-cloud offre la flexibilité et évite le verrouillage des fournisseurs. Lors de l'évaluation des fournisseurs de stockage potentiels, il convient d'envisager (i) de donner la priorité aux fournisseurs ayant des accords de niveau de service (SLA) accords de niveau de service (SLA) élevés (par exemple, 99,99 % et plus de temps de disponibilité), (ii) évaluer les risques de verrouillage du stockage en dépendant fortement des outils et formats de stockage propriétaires d'un seul fournisseur, ce qui peut poser des problèmes s'il est nécessaire de changer de fournisseur ultérieurement, (iii) assurer une migration en douceur des charges de travail et du stockage afin de préserver l'agilité.

Conclusion

Le succès de l'IA dans le nuage dépend d'une gestion efficace des données qui relie le progrès technologique à la valeur commerciale. Les données doivent être optimisées en termes d'échelle, de sécurité, de performance, de coût et de conformité tout au long de leur cycle de vie.

Les technologies cloud offrent des plateformes évolutives et flexibles pour gérer des modèles de données d'IA complexes. En tirant parti des solutions et des meilleures pratiques natives du cloud, les entreprises peuvent stimuler l'innovation et permettre une prise de décision éclairée. Les stratégies d'ingestion de données que nous avons explorées prennent en charge divers flux de données dans les systèmes d'IA, permettant à la fois le traitement en temps réel et par lots avec une faible latence et un débit élevé.

À l'avenir, la gestion des données d'IA continuera d'évoluer avec une gouvernance automatisée, des " lakehouses " sans serveur, des architectures préservant la vie privée et des pratiques durables. Les chefs d'entreprise et les architectes devraient donner la priorité à l'investissement dans une infrastructure de données et une gouvernance modernes basées sur le cloud pour pérenniser les capacités d'IA et promouvoir la collaboration interfonctionnelle, en alignant les stratégies de données sur les objectifs de l'entreprise.

Prêt à passer à l'étape suivante de l'innovation alimentée par l'IA ? Si vous avez besoin d'aide pour mettre à l'échelle ou construire votre infrastructure d'IA, contactez-nous dès aujourd'hui, contactez-nous dès aujourd'hui.