Les examens manuels et les outils tels que SAST et DAST sont toujours essentiels, mais ils se heurtent à des problèmes d'échelle, de contexte et de rapidité de remédiation. Avec des volumes croissants de code - et de plus en plus de code écrit par l'IA - les organisations ont besoin de moyens plus rapides et plus intelligents pour repérer et corriger les failles de sécurité.

C'est là que l'IA commence à changer le fonctionnement de la sécurité des applications. Les outils modernes ne se contentent pas de détecter les vulnérabilités ; ils suggèrent des correctifs, expliquent les problèmes en langage clair et s'intègrent aux flux de travail des développeurs. Dans cet article, nous allons explorer l'utilisation de l'IA dans la sécurité des applications : comment elle détecte et corrige les vulnérabilités, comment les équipes adoptent ces outils aujourd'hui, où ils sont insuffisants, et à quoi ressemble l'avenir de la sécurité alimentée par l'IA.

Comment l'IA améliore la sécurité des applications

L'IA remodèle la sécurité des applications en allant au-delà des méthodes de détection traditionnelles. Alors que les outils tels que SAST et DAST se concentrent sur l'identification et la classification des vulnérabilités, les systèmes d'IA appliquent une compréhension plus approfondie du code pour offrir des solutions contextuelles et exploitables. Il en résulte une détection plus rapide, un triage plus intelligent et, de plus en plus, une remédiation automatisée. Voici les principales façons dont l'IA améliore l'AppSec aujourd'hui :

Détection automatisée des vulnérabilités et hiérarchisation

Les systèmes d'IA utilisent de grands modèles de langage (LLM) et l'apprentissage automatique pour comprendre la structure du code, le flux de données et l'intention. La compréhension approfondie du code permet aux LLM d'effectuer une détection plus précise des vulnérabilités et une hiérarchisation intelligente en fonction de la gravité et de l'exploitabilité.

Prise en charge de l'examen du code en temps réel

Contrairement à l'analyse post-commit traditionnelle, les outils d'IA s'intègrent directement dans les IDE et les pipelines de CI, prenant en charge une véritable sécurité "shift-left". Des programmes tels que GitHub Copilot avec CodeQL, les plugins IDE de Snyk et Qwiet AI fournissent un retour d'information en ligne pendant le développement, en mettant en évidence les modèles de code non sécurisés, en expliquant le risque et en suggérant des corrections pendant que les développeurs écrivent ou révisent le code, tout cela dans le cadre de leur flux de travail existant.

De la détection à la remédiation

La capacité de l'IA à suggérer et à appliquer des correctifs constitue une avancée significative. Les outils traditionnels se contentaient de signaler les problèmes ; les outils d'IA fournissent désormais des solutions exploitables, transformant le flux de travail de la sécurité de "voici un problème" à "voici comment le résoudre".

Autofixation en fonction du contexte

L'une des caractéristiques les plus importantes des outils de sécurité basés sur l'IA est leur capacité à générer eux-mêmes des correctifs ciblés. Les systèmes de correction automatique suivent généralement un processus structuré :

Examiner le code : Soumettre l'extrait de code bogué à l'IA pour analyse.

Ajouter un contexte : Fournir des règles de sécurité et des bonnes pratiques

Trouver le problème : analyser le flux de code et les données pour comprendre la faille de sécurité.

Créer un correctif : Écrire un nouveau code qui corrige le problème tout en permettant au programme de continuer à fonctionner.

La correction de la sécurité par l'IA se concentre uniquement sur les parties défectueuses plutôt que de réécrire des fonctions entières. Plusieurs entreprises proposent des outils dotés de cette capacité, tels que :

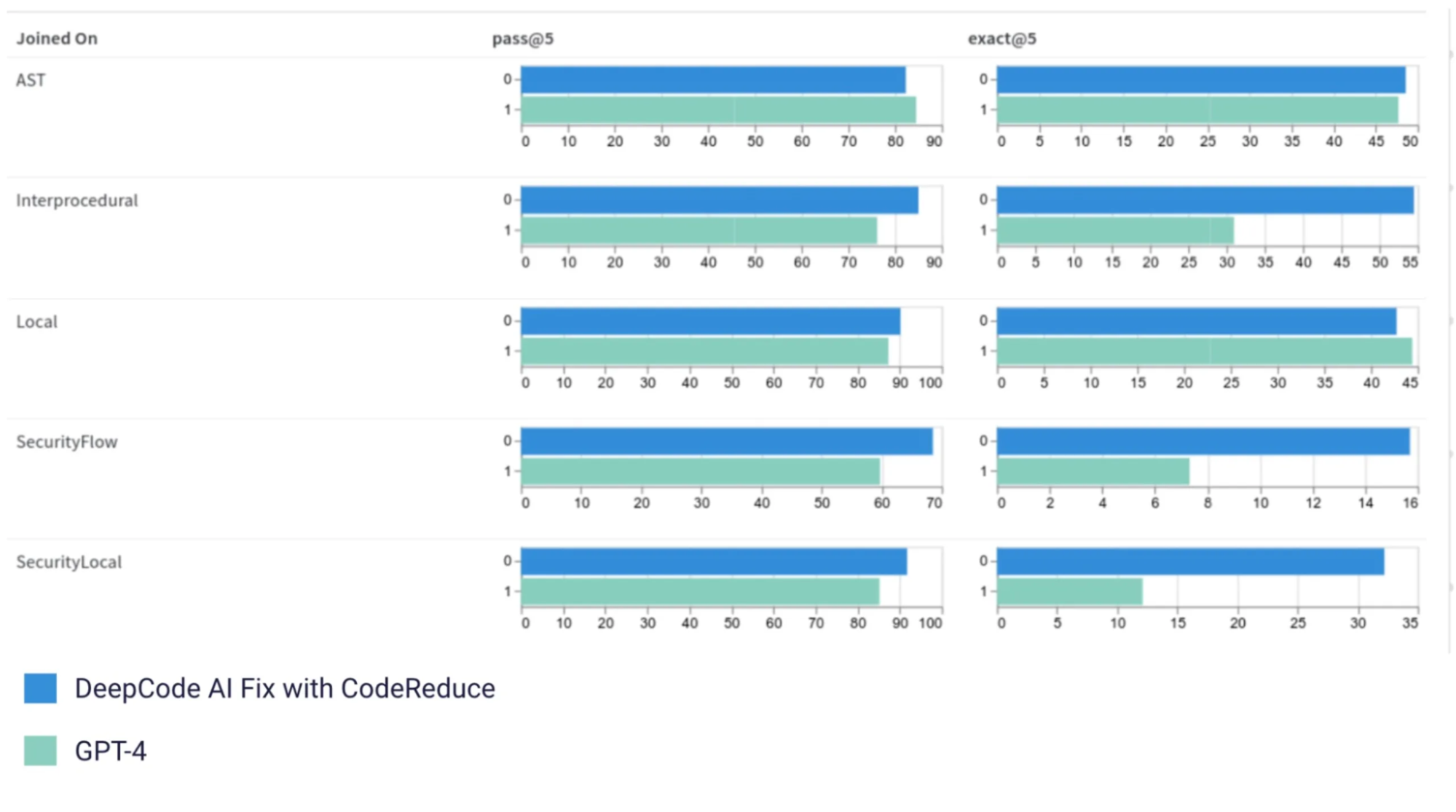

Snyk DeepCode AI Fix combine les LLM avec des techniques d'analyse statique. Il a commencé avec le modèle T5 de Google mais utilise désormais StarCoderqui est formé sur des problèmes de sécurité résolus. La technologie CodeReduce de Snyk concentre l'IA uniquement sur les sections de code vulnérables, ce qui permet d'obtenir une précision jusqu'à 20 % supérieure à celle du modèle GPT-4 tout en réduisant le nombre de faux positifs. Le système MergeBack assure une intégration propre des correctifs dans les bases de code existantes.

Source de l'image : Article de blog de Snyk

AutoFix de Qwiet AI de Qwiet AI utilise plusieurs agents d'intelligence artificielle travaillant avec le graphique des propriétés du code (CPG). Le CPG cartographie le fonctionnement d'une application, en montrant le flux de données et la structure du code en une seule vue. Cette approche est excellente pour les vulnérabilités complexes telles que les conditions de course et les attaques par injection SQL.

GitHub Copilot AutoFix fournit des suggestions de correction en temps réel directement dans les éditeurs de code pour les vulnérabilités détectées par CodeQL . Il aide les développeurs à appliquer des modèles de codage sécurisés au fur et à mesure qu'ils écrivent, réduisant ainsi le changement de contexte et améliorant la vitesse de correction au sein de flux de travail familiers.

CodeRabbit propose des révisions de code assistées par l'IA directement dans les demandes d'extraction GitHub. Il peut identifier les problèmes de sécurité, suggérer des correctifs adaptés au contexte et soutenir les boucles de rétroaction des développeurs, le tout sans quitter l'interface utilisateur de GitHub. Dans notre récent webinaire sur l'IA avec CodeRabbitles PME ont expliqué comment CodeRabbit apporte l'IA à vos révisions de code, vous aidant à économiser jusqu'à 50 % du temps consacré aux révisions manuelles.

Réduction des faux positifs grâce au contexte du code

Les scanners traditionnels produisent souvent des résultats bruyants en raison d'une compréhension limitée du comportement du code. Les outils d'IA améliorent la précision en analysant :

la manière dont les données circulent dans les fonctions et les modules

Si l'entrée est assainie ou validée

les schémas de codage sécurisés courants

la différence entre les risques théoriques et les failles exploitables.

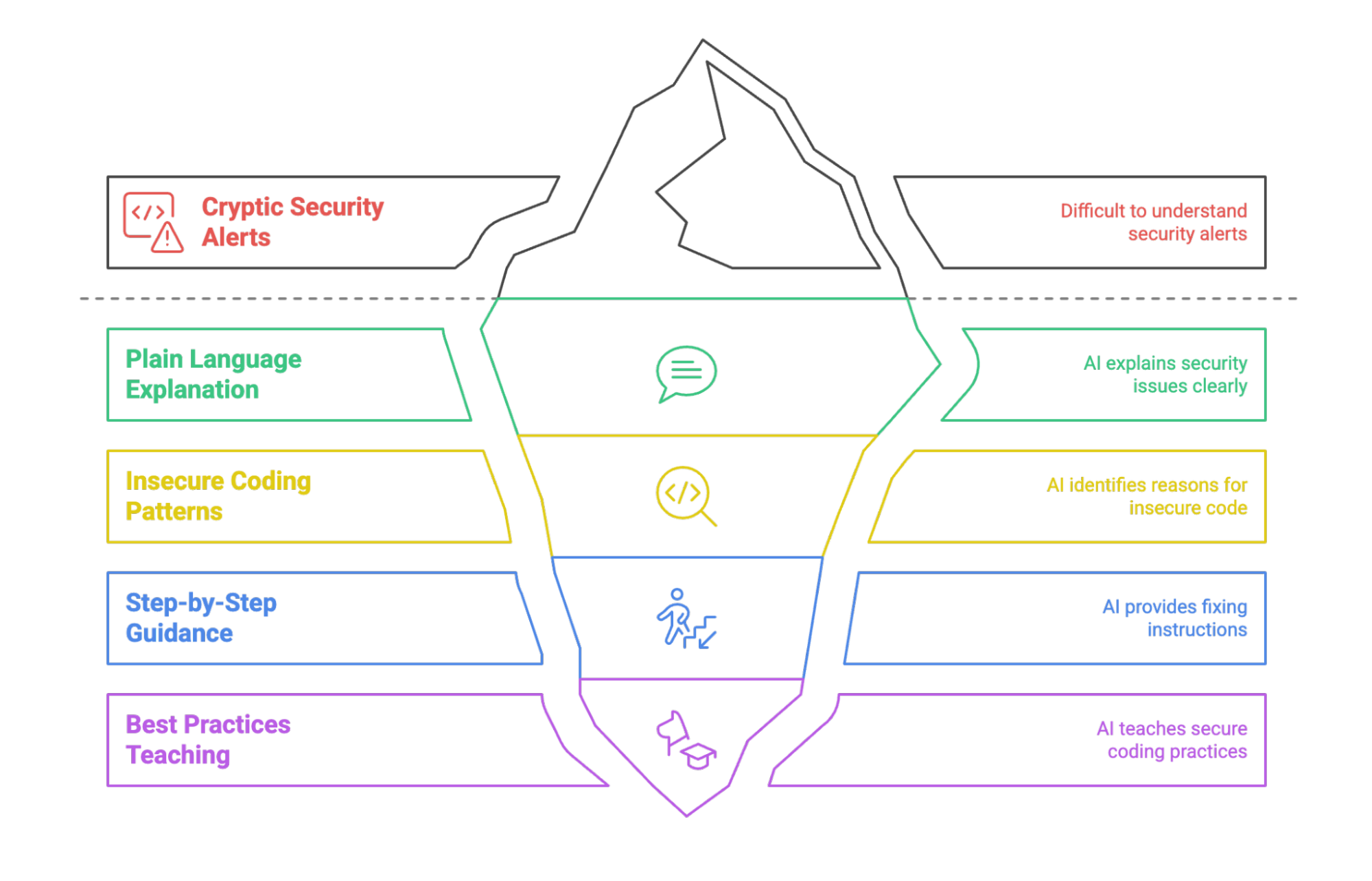

Des conseils en langage naturel pour les développeurs

L'IA transforme les alertes de sécurité cryptiques en conseils exploitables :

expliquant les problèmes en langage clair

mettant en évidence les raisons pour lesquelles un modèle de codage n'est pas sûr

en fournissant des conseils de correction étape par étape

Enseignant les meilleures pratiques au fur et à mesure que vous travaillez

Par exemple, dans une véritable demande d'extraction GitHubCodeRabbit a fourni un retour d'information complet tel que :

"CRITICAL : Corriger de graves erreurs de configuration de sécurité dans le seau S3. La configuration actuelle présente plusieurs problèmes de sécurité critiques : L'accès public en lecture est activé via ACL, la politique CORS autorise les requêtes de n'importe quelle origine, tous les en-têtes sont autorisés. Ces paramètres peuvent entraîner un accès non autorisé, une fuite de données et un abus potentiel de vos ressources S3."

L'IA a ensuite fourni des correctifs de code spécifiques, expliqué les implications en matière de sécurité et suggéré des améliorations architecturales, allant bien au-delà de la simple détection des vulnérabilités pour fournir des conseils de révision de code approfondis qui aident les développeurs à comprendre à la fois le problème et la solution.

De même, GitHub Copilot peut suggérer des corrections en ligne tout en offrant des explications en langage naturel basées sur l'analyse CodeQL. Ces informations aident les développeurs à comprendre la vulnérabilité et à appliquer un correctif sans quitter leur environnement de codage.

Ensemble, ces avancées aident les équipes à corriger les bogues plus tôt, à réduire le temps consacré au triage et à maintenir un code sécurisé avec moins de travail manuel. Avec ces avancées en place, examinons comment les organisations mettent en pratique la sécurité alimentée par l'IA aujourd'hui.

Comment les entreprises utilisent l'IA pour l'AppSec en 2025

Les organisations intègrent des outils de sécurité IA dans de multiples modèles de déploiement :

Intégration de l'environnement de développement : Les équipes intègrent les outils de sécurité IA directement dans les IDE tels que VS Code, IntelliJ et Visual Studio. Les développeurs reçoivent des alertes de vulnérabilité en temps réel et des suggestions de correction lorsqu'ils écrivent du code, avec des outils tels que GitHub Copilot Security et les extensions IDE de Snyk qui mènent l'adoption.

Intégration du pipeline CI/CD : Les organisations intègrent l'analyse de sécurité de l'IA dans les flux de travail d'intégration continue. Les outils analysent automatiquement les commits de code, les pull requests et les builds, et bloquent les déploiements lorsque des vulnérabilités critiques sont détectées. Les entreprises signalent un codage sécurisé 55 % plus rapide avec GitHub Copilot et jusqu'à 60 % plus rapide pour remédier aux vulnérabilités avec Snyk.

Automatisation de l'examen de la sécurité : Les équipes de sécurité utilisent des outils d'IA pour compléter les examens manuels du code, en signalant automatiquement les problèmes potentiels pour une vérification humaine. Cette approche hybride combine la vitesse de l'IA avec l'expertise humaine pour une prise de décision critique.

Remédiation des codes hérités : Les organisations utilisent des outils d'IA pour analyser et corriger les vulnérabilités dans les bases de code existantes. Qwiet AI rapporte jusqu'à 95% de réduction des temps de correction pour les schémas de vulnérabilité les plus courants lorsqu'ils sont appliqués aux systèmes existants.

Formation et transfert de connaissances : Les équipes de développement utilisent les explications et les suggestions de correction générées par l'IA comme outils d'apprentissage, renforçant ainsi leur expertise en matière de sécurité tout en traitant les vulnérabilités immédiates.

L'adoption actuelle se concentre sur les types de vulnérabilités courantes, l'injection SQL, les scripts intersites (XSS), les failles d'authentification et la manipulation dangereuse des données, pour lesquelles les outils d'IA font preuve de la plus grande précision et de la plus grande fiabilité.

Les défis de l'adoption dans le monde réel

Malgré des capacités prometteuses, les outils de sécurité de l'IA posent plusieurs problèmes lorsqu'il s'agit de les adopter dans le monde réel :

Qualité et précision des corrections : Si une précision de 80 % représente un progrès considérable, le taux d'échec de 20 % pose de sérieux risques. Des correctifs incomplets ou incorrects peuvent introduire de nouvelles vulnérabilités ou briser la fonctionnalité d'une application.

Lacunes dans le contexte au niveau du système : De nombreux outils peuvent désormais analyser des dossiers ou des fichiers multiples, mais des limites subsistent, en particulier dans les grandes bases de code ou les environnements de microservices. Les correctifs suggérés peuvent fonctionner de manière isolée, mais échouer lorsqu'ils sont appliqués à des systèmes interconnectés sans contexte plus large.

Complexité de l'intégration : Les organisations ont du mal à intégrer les outils de sécurité de l'IA dans les flux de travail d'approbation existants, les politiques de sécurité et les exigences de conformité. Les formats de sortie incohérents et l'absence de rapports normalisés (comme le SARIF) compliquent l'intégration.

Préoccupations en matière de confidentialité et de traitement des données : Certains outils s'appuient sur des modèles de grands langages basés sur le cloud, ce qui peut poser des risques en matière de confidentialité ou de conformité lors de l'analyse de codes propriétaires ou sensibles. Les organisations des secteurs réglementés tels que la finance, la défense et le gouvernement peuvent hésiter à adopter des outils qui transmettent le code à des serveurs externes sans garanties claires sur l'utilisation et la conservation des données.

Explicabilité et confiance des développeurs : Les développeurs sont plus enclins à agir sur les suggestions de l'IA lorsqu'ils en comprennent la raison. Si des outils comme GitHub Copilot et CodeRabbit offrent des explications en ligne, d'autres fonctionnent encore comme des boîtes noires, ce qui rend plus difficile la confiance dans les changements automatisés, en particulier dans les systèmes à fort enjeu.

Variabilité des performances : L'efficacité des outils d'IA varie considérablement selon les types de vulnérabilités, les langages de programmation et les modèles architecturaux. Les outils qui excellent dans la détection des vulnérabilités des applications web peuvent éprouver des difficultés avec les systèmes intégrés ou les implémentations cryptographiques.

Prochaine étape : des agents plus sûrs et plus intelligents

Le paysage de la sécurité de l'IA évolue vers des solutions plus sophistiquées, tenant compte du contexte :

Compréhension complète du code : Les outils d'analyse de code alimentés par l'IA, tels que CodeRabbit et GitHub Copilot with CodeQL, analysent déjà plusieurs fichiers et modules pour comprendre la structure générale du code. La prochaine vague renforcera cette analyse en incorporant la logique interservices, la résolution des dépendances et des connaissances architecturales plus approfondies.

Intégration intelligente des flux de travail : Les outils d'IA sont de plus en plus souvent intégrés directement dans les demandes d'extraction, les pipelines CI/CD et les IDE. Par exemple, CodeRabbit fonctionne dans les PR de GitHub et suggère des corrections sans perturber le flux de révision. Il faut s'attendre à une intégration plus étroite avec les systèmes de suivi des problèmes, les flux de travail d'approbation et les moteurs de politique...

Assistance conversationnelle en matière de sécurité : Les interfaces basées sur le chat permettent aux développeurs d'itérer sur les correctifs par le biais du langage naturel, en affinant les solutions en collaboration avec l'aide de l'IA.

Apprentissage spécifique à l'organisation : Les systèmes avancés s'adapteront aux normes de codage, aux modèles architecturaux et aux politiques de sécurité propres à l'entreprise, en fournissant des recommandations de plus en plus personnalisées au fil du temps.

Amélioration de la hiérarchisation des risques : Des systèmes de notation améliorés prendront en compte le contexte de l'entreprise, la sensibilité des données et le paysage des menaces pour aider les équipes à se concentrer d'abord sur les vulnérabilités les plus critiques.

Plus de fonctionnalités: Les développeurs veulent affiner le comportement des outils. Des fonctionnalités telles que la suppression des alertes, l'analyse ciblée, la configuration des politiques et l'analyse des dépendances deviennent des attentes standard, et non plus des options.

Conclusion : faire évoluer la sécurité vers la gauche, avec intelligence

Les outils de sécurité des applications alimentés par l'IA représentent un changement fondamental de la détection réactive à la remédiation proactive. En automatisant la découverte des vulnérabilités et en suggérant des correctifs adaptés au contexte, les outils d'IA permettent aux développeurs de s'attaquer aux problèmes de sécurité plus tôt dans le cycle de développement, réduisant ainsi les coûts et les risques.

J'espère que cet aperçu a permis de clarifier la façon dont l'IA est actuellement utilisée dans la sécurité des applications et ce que la prochaine vague de technologie pourrait apporter à l'AppSec. Pour en savoir plus sur les dernières nouveautés en matière d'IA, contactez-nous !