Retos comunes en la arquitectura de datos

Las organizaciones experimentan con frecuencia silos de datos y conexiones "punto a punto", en las que los equipos crean conexiones directas entre las fuentes de datos y los consumidores. Al principio, este enfoque puede parecer manejable, pero a medida que se añaden más conexiones y almacenes de datos, el sistema se convierte en una maraña, difícil de mantener y frágil. El resultado es una falta de transparencia, fiabilidad y eficacia.

Una solución eficaz es adoptar una arquitectura basada en eventos. Muchas organizaciones confían en Apache Kafka y Confluent Cloud para permitir el flujo de datos en tiempo real. Aunque las arquitecturas basadas en eventos ofrecen un enfoque prometedor, también plantean sus propios retos. Sin una planificación adecuada, las organizaciones pueden acabar recreando la misma compleja red de conexiones que pretendían resolver. A continuación se exponen algunas consideraciones clave para una implantación satisfactoria.

Elementos clave para el éxito de un marco de datos en tiempo real

1. 1. Escalabilidad y resistencia

a) La escalabilidad garantiza que su plataforma de datos pueda crecer con su organización. El empleo de soluciones como Kubernetes y herramientas de infraestructura como código (por ejemplo, Terraform) ayuda a automatizar y escalar la infraestructura. El almacenamiento por niveles, que almacena los datos en capas calientes (a las que se accede con frecuencia) y frías (a las que se accede con poca frecuencia), mejora aún más la flexibilidad al hacer que los datos estén disponibles sin elevados costes de almacenamiento.

b) La resistencia consiste en crear una infraestructura capaz de hacer frente a los fallos sin pérdidas de datos significativas ni tiempos de inactividad. Establecer rutas de datos redundantes y aprovechar los mecanismos de autorreparación de herramientas como Kafka garantiza un flujo de datos continuo, incluso si partes del sistema experimentan interrupciones.

2. Gobernanza y seguridad

a) La gobernanza de datos implica establecer la validación de esquemas, los controles de acceso y la gestión de metadatos para garantizar la calidad de los datos y mantener la coherencia entre los sistemas. El uso de catálogos de datos y esquemas estandarizados ayuda a los usuarios a confiar en los datos que consumen.

b) La seguridad comienza con controles de acceso detallados, como el control de acceso basado en roles (RBAC), para limitar quién puede acceder a datos específicos. El cifrado a nivel de campo puede proteger aún más la información sensible, reduciendo el riesgo de exposición y manteniendo la usabilidad.

3. Observabilidad

a) Una alta observabilidad es esencial para supervisar la salud y el flujo de datos en todo el sistema. Herramientas como Stream Lineage de Confluent y OpenTelemetry proporcionan visibilidad del recorrido de los datos, desde el origen hasta el destino. Esta transparencia genera confianza, ya que los usuarios pueden realizar un seguimiento de los problemas, revisar los datos históricos y asegurarse de que los datos llegan a su destino según lo previsto.

4. Experiencia del desarrollador

a) Crear un entorno fácil de usar para los desarrolladores es crucial para la adopción. Las herramientas que ofrecen un descubrimiento de datos fluido, como el catálogo de datos de Confluent, reducen la fricción a la que se enfrentan los desarrolladores a la hora de localizar y utilizar los datos. Además, fomentar un entorno de colaboración con estándares compartidos para trabajar con datos en tiempo real fomenta la innovación y alinea a los equipos con las mejores prácticas.

Evitar errores comunes

La creación de una plataforma de datos en tiempo real conlleva retos que, si no se controlan, pueden hacer fracasar el proyecto:

Deuda técnica: Omitir la gobernanza o la observabilidad durante las primeras fases de desarrollo puede dar lugar a complicaciones en el futuro, ya que los consumidores de datos se vuelven dependientes de las implementaciones iniciales. Evite acumular deuda técnica implementando estos componentes desde el principio.

Gobernanza reactiva: Ser proactivo en las políticas de gobernanza garantiza un tratamiento coherente de los datos en toda la organización. Un enfoque reactivo, en el que las restricciones o políticas de datos se aplican sólo después de que surja un problema, a menudo da lugar a una gobernanza desarticulada o incompleta.

Falta de normas centralizadas: Cuando los departamentos o equipos desarrollan normas de tratamiento de datos independientes, el sistema resultante carece de cohesión. Establecer un centro de excelencia puede ayudar a estandarizar las prácticas y crear una estrategia de datos unificada en toda la organización.

Aplicaciones reales de la arquitectura basada en eventos

Varios casos de uso en el mundo real ponen de relieve las ventajas de un marco sólido basado en eventos:

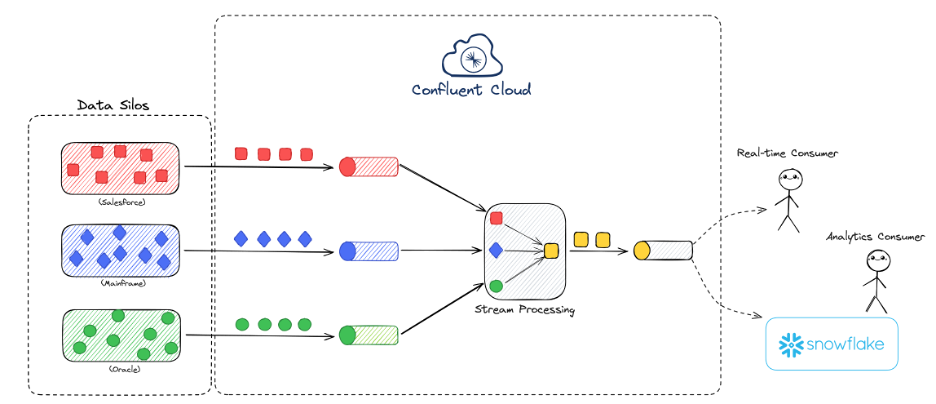

Liberación de datos: La eliminación de los silos de datos permite el acceso en tiempo real a información que antes estaba bloqueada en departamentos específicos. Por ejemplo, utilizando Confluent Cloud, las organizaciones pueden agregar datos de varios sistemas, transformando fuentes de datos fragmentadas en productos unificados y localizables. Este enfoque mejora la accesibilidad de los datos, reduce la sobrecarga asociada a las conexiones punto a punto y abre nuevas posibilidades para las cargas de trabajo en tiempo real.

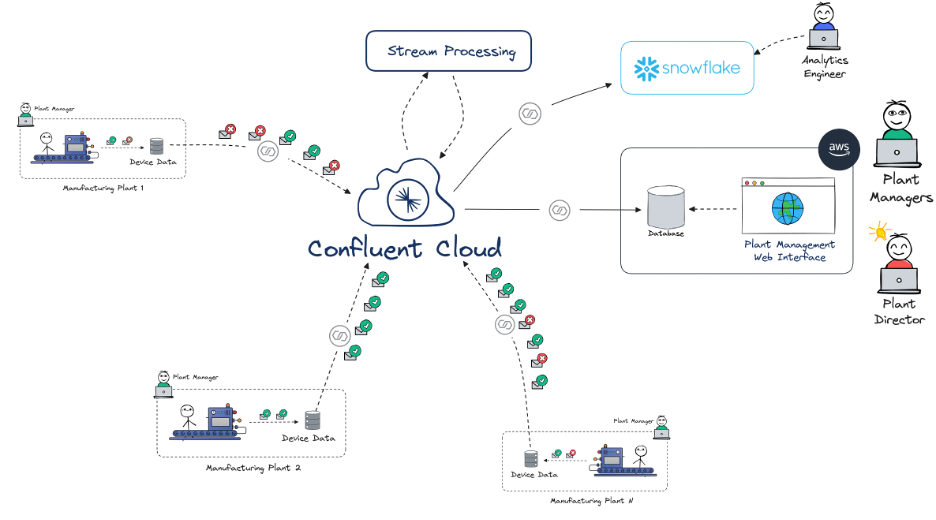

Visibilidad centralizada de los datos: En la fabricación, por ejemplo, las plantas pueden utilizar plataformas de datos centralizadas para supervisar y analizar el rendimiento de las máquinas en tiempo real, lo que permite un mantenimiento predictivo y reduce el tiempo de inactividad. Al integrar los datos de IoT de varias ubicaciones en un flujo único y coherente, la dirección puede tomar decisiones oportunas e informadas basadas en los últimos datos disponibles en toda la red de fabricación.

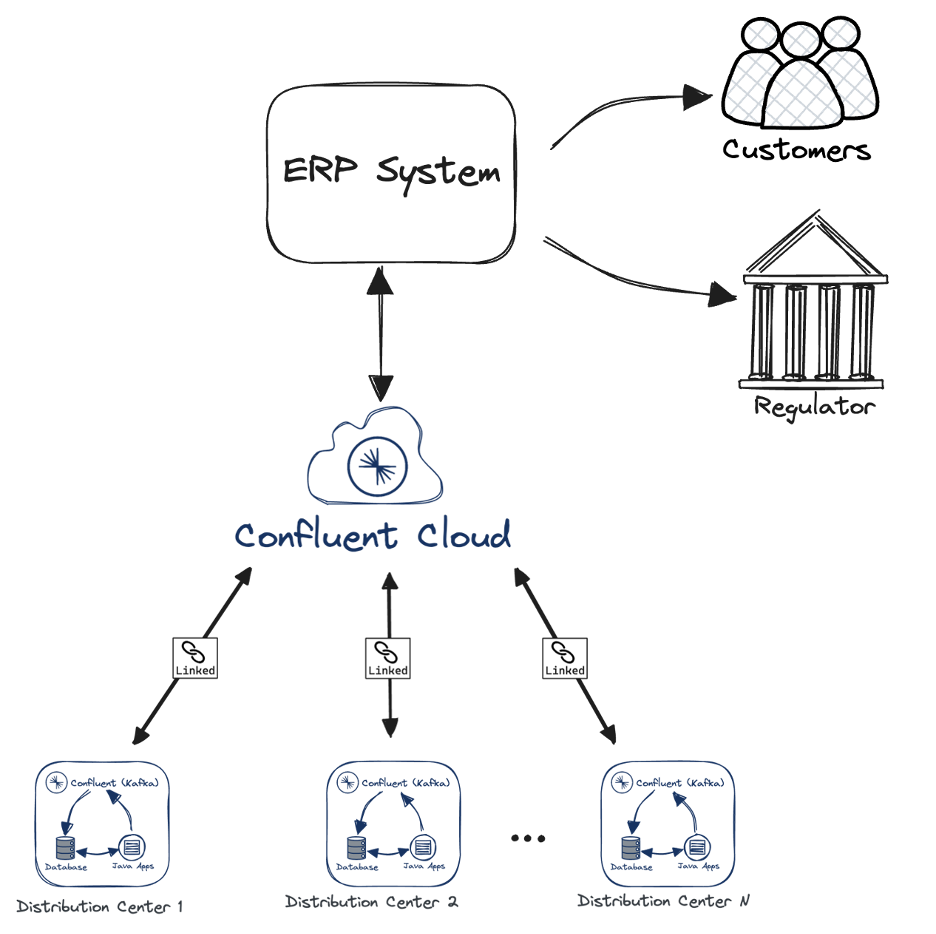

Trazabilidad en tiempo real: En logística, garantizar la trazabilidad de los productos en todos los centros de distribución minimiza el riesgo operativo. Utilizando herramientas como Kafka y Confluent Cloud con vinculación de clústeres, se configuró una implantación de centros de distribución automatizada y repetible. Una vez implementada en todos los centros, las organizaciones pueden realizar un seguimiento de los movimientos de los productos en tiempo real, lo que proporciona una visibilidad completa de la cadena de custodia y permite una resolución rápida de posibles problemas con redundancia total para evitar interrumpir la continuidad de la actividad empresarial.

Dar el primer paso

Las organizaciones que deseen implantar estrategias de datos en tiempo real pueden beneficiarse de un enfoque estructurado para identificar e implementar casos de uso. Empezar con un único caso de uso permite a los equipos validar el enfoque, evaluar su impacto y perfeccionar sus procesos. A medida que estos primeros logros demuestran su valor, la plataforma de datos puede ampliarse para dar soporte a casos de uso más amplios y complejos, creando una arquitectura de datos resistente, segura y preparada para el futuro.

La arquitectura de datos en tiempo real es una inversión en agilidad organizativa. Al abordar estos elementos básicos -escalabilidad, seguridad, capacidad de observación y experiencia del desarrollador-, las empresas pueden crear una plataforma que no sólo satisfaga las necesidades actuales, sino que también se adapte a los retos del mañana.

Si te perdiste la presentación completa, asegúrate de explorar la sección Tecnología del mañana. Today para obtener más información sobre IA, ecosistemas de datos e ingeniería de plataformas.